Python、Kaggle、Spark:2025年数据科学三大神器,从入门到精通的黄金学习路径

** 想在数据科学领域脱颖而出?掌握这三大工具的协同作战能力,让你的简历和项目经验瞬间“亮”起来!

(Meta Description 百度搜索展示用):

本文深入解析Python、Kaggle、Spark这三大数据科学核心工具,文章不仅详细介绍了每个工具的独特优势,更重要的是阐述了它们如何协同工作,形成一套完整的数据科学解决方案,无论你是初学者还是希望提升技能的从业者,这份从数据获取、探索性分析到大规模处理的黄金学习路径,都将助你高效提升竞争力,轻松驾驭复杂数据分析项目。

引言:为什么是Python + Kaggle + Spark?

在数据驱动的时代,数据科学已成为最具价值的技能之一,面对海量的学习资源和工具,许多初学者和从业者常常感到迷茫:我该学什么?如何将零散的知识点串联成解决实际问题的能力?

答案其实非常明确,那就是Python、Kaggle和Spark,这三者并非孤立存在,而是构成了一个强大且高效的数据科学工作流:

- Python:作为胶水语言和通用编程利器,是数据科学的“瑞士军刀”。

- Kaggle:作为全球最大的数据科学社区和竞赛平台,是理论联系实际的“练兵场”和“试金石”。

- Apache Spark:作为分布式计算引擎,是处理海量数据的“超级航母”。

本文将为你揭示这三者如何珠联璧合,并为你规划一条清晰、可执行的黄金学习路径。

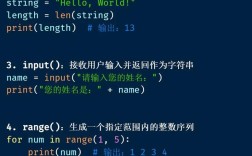

第一部分:Python——数据科学的基石与灵魂

Python之所以能成为数据科学领域的绝对霸主,并非偶然,它拥有无与伦比的生态系统和简洁的语法,让数据科学家能够专注于业务逻辑,而非复杂的编程细节。

核心优势:

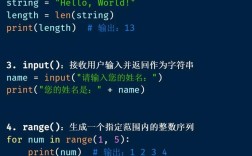

- 语法简洁,易于上手: 接近自然语言的语法让初学者能快速入门,并将更多精力投入到数据分析本身。

- 强大的库生态: 这是Python的王牌。

- NumPy:科学计算基础,提供高性能的多维数组对象。

- Pandas:数据分析的瑞士军刀,提供了DataFrame等强大的数据结构,让数据清洗、转换、聚合变得异常简单。

- Matplotlib & Seaborn:数据可视化库,能轻松创建出丰富、美观的图表,洞察数据背后的故事。

- Scikit-learn:机器学习库,涵盖了几乎所有经典机器学习算法,从回归到分类,从聚类到降维,应有尽有。

- Jupyter Notebook/Lab:交互式开发环境,支持代码、文本、公式和可视化图表的完美融合,是数据探索和结果展示的理想选择。

学习建议:

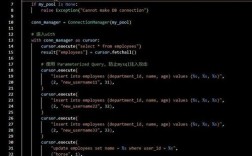

- 打好基础: 熟练掌握Python基础语法、函数、面向对象编程。

- 精通Pandas: 将80%的精力花在Pandas上,因为数据清洗和预处理占据了数据科学家工作的80%时间,熟练掌握

groupby,merge,pivot_table等核心操作。 - 实践驱动: 不要只看书,用Jupyter Notebook跟着教程敲代码,并尝试用真实的小数据集进行练习。

第二部分:Kaggle——从理论到实践的桥梁

如果说Python是你的武器,那么Kaggle就是你的战场和军火库,它是将理论知识转化为实战能力的最佳平台。

核心价值:

- 真实世界的数据集: Kaggle提供了来自各行各业、各行各业的真实数据集,大小不一,问题各异,你可以在这里找到练习、验证和展示自己技能的绝佳素材。

- 顶级的学习社区: 你可以在这里学习到世界级数据科学家的解决方案(Notebook),通过阅读、复现和改进他人的代码,你的成长速度会呈指数级增长。

- 竞赛驱动的动力: Kaggle竞赛不仅能带来荣誉和奖金,更能锻炼你在压力下解决复杂问题的能力、特征工程的能力和模型调优的能力。

- 求职的加分项: 一个活跃的Kaggle主页和不错的竞赛排名,是向雇主证明你实战能力的有力证据。

学习建议:

- 从“Getting Started”竞赛做起: Titanic: Machine Learning from Disaster”,这类竞赛入门门槛低,能让你完整走一遍数据科学流程。

- “抄作业”与“超越作业”: 认真研读高排名选手的Notebook,理解他们的思路和代码,不要满足于复制,尝试加入自己的思考,比如使用不同的模型、进行更深入的特征交叉。

- 参与讨论: 积极参与论坛讨论,提问和回答问题,教学相长,解释一个概念会让你理解得更深刻。

第三部分:Spark——驾驭大数据的引擎

当你处理的PB级数据单机内存无法容纳时,Python和Pandas就无能为力了,这时,Apache Spark就闪亮登场了。

核心优势:

- 分布式计算: Spark的核心是其分布式内存计算框架,它可以将一个大的计算任务拆分成多个小任务,在由多台机器组成的集群上并行处理,从而实现对海量数据的快速处理。

- 速度优势: 相比传统的Hadoop MapReduce,Spark由于基于内存计算,速度要快上几个数量级。

- 统一的分析引擎: Spark不仅仅是一个数据处理工具,它还是一个统一的平台,集成了Spark SQL(用于结构化数据处理)、MLlib(用于机器学习)、GraphX(用于图计算)和Spark Streaming(用于流处理)。

- 与Python的无缝集成: PySpark是Spark的Python API,让你可以用熟悉的Python语言来编写Spark程序,极大地降低了学习门槛。

学习建议:

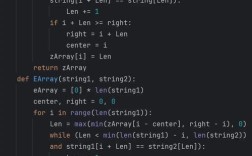

- 理解核心概念: 学习Spark,首先要理解其核心概念:RDD(弹性分布式数据集)、DataFrame、SparkSession、Transformation(转换)和Action(行动),理解惰性求值是关键。

- 从PySpark开始: 利用PySpark,将你之前用Pandas处理数据的逻辑,用Spark的方式重写一遍,用

spark_df.show()代替pandas_df.head(),用groupby()和agg()进行聚合。 - 掌握Spark SQL: 对于有SQL背景的数据分析师来说,Spark SQL非常友好,学习使用SQL语句来查询DataFrame,往往比用复杂的链式操作更直观。

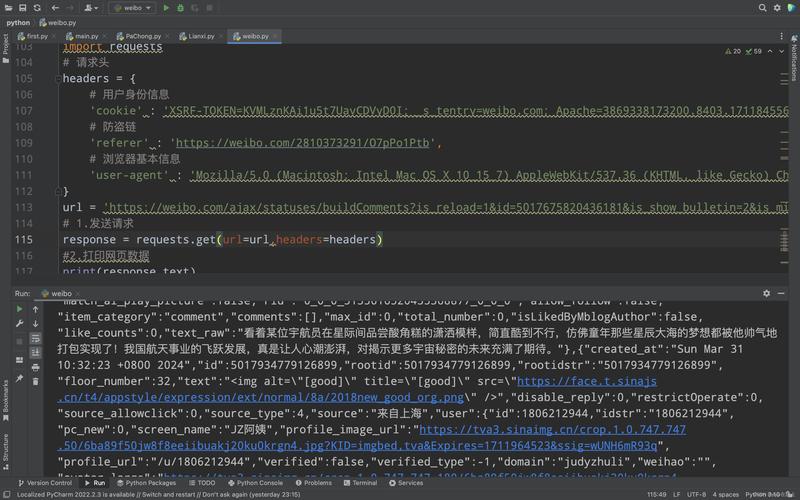

第四部分:黄金协同:Python + Kaggle + Spark 的无敌组合

单独掌握任何一个工具都很强,但将它们结合起来,才能发挥出1+1+1 > 3的巨大威力,一个典型的大数据科学项目流程如下:

-

数据获取与初步探索 (Python + Kaggle):

- 在Kaggle上找到一个你感兴趣的大型数据集(数百万行级别的用户行为日志)。

- 使用Python的

pandas库进行初步加载和探索,如果数据量不大,可以直接在本地用Pandas完成EDA(探索性数据分析)。 - 如果数据量过大,单机Pandas无法处理,则进入下一步。

-

大规模数据处理与特征工程 (Python + Spark):

- 启动一个本地或集群的Spark环境,创建

SparkSession。 - 使用PySpark加载数据集到

DataFrame中。 - 利用Spark SQL和DataFrame API进行数据清洗(处理缺失值、异常值)、数据转换和大规模特征工程,对数百万用户的点击流数据进行窗口函数计算,生成用户画像特征。

- 这是Spark大显身手的阶段,处理速度远超传统单机工具。

- 启动一个本地或集群的Spark环境,创建

-

模型训练与评估 (Python + Spark):

- 将处理好的数据通过

.toPandas()方法(如果结果集不大)或使用MLlib库,转换为适合机器学习模型的形式。 - 方案A (推荐): 使用

Spark MLlib进行模型训练,MLlib提供了可扩展的机器学习算法库,可以直接在分布式数据上进行训练,避免了数据收集到单点的瓶颈。 - 方案B: 将Spark处理好的数据抽样或聚合后,导出为CSV/Parquet文件,再使用

scikit-learn或XGBoost等在本地或更大规模的机器上进行模型训练,这种方式更灵活,可以调用更丰富的第三方库。

- 将处理好的数据通过

-

结果分析与项目展示 (Python + Kaggle):

- 使用Python的

matplotlib和seaborn对模型结果进行可视化,生成洞察报告。 - 将你的整个流程、代码、分析和结论整理成一个精美的Jupyter Notebook。

- 将这个Notebook发布到Kaggle的对应数据集页面,与社区分享,或者作为你求职时的项目作品集。

- 使用Python的

你的学习路线图

-

第一阶段:Python基础与Pandas精通 (1-2个月)

- 目标:能够独立完成中小型数据集的清洗、分析和可视化。

- 行动:系统学习Python,并通过Kaggle上的“Getting Started”竞赛和Notebook来实践Pandas。

-

第二阶段:Kaggle实战与机器学习入门 (2-3个月)

- 目标:熟悉完整的数据科学流程,掌握基本的机器学习模型。

- 行动:参与1-2个Kaggle竞赛,完整复现多个高排名Notebook,学习并使用Scikit-learn。

-

第三阶段:Spark入门与PySpark应用 (2-3个月)

- 目标:理解Spark原理,能够使用PySpark处理GB/TB级别的数据。

- 行动:搭建本地Spark环境,学习PySpark API,尝试用Spark重写之前用Pandas处理过的任务,并逐步挑战更大的数据集。

-

第四阶段:三者的融合与进阶 (持续进行)

- 目标:构建端到端的大数据科学解决方案。

- 行动:寻找一个综合性的项目,完整地走一遍“获取-探索-处理-建模-展示”的全流程,将三大工具融会贯通。

Python、Kaggle和Spark是数据科学家和分析师的“三驾马车”,它们各自强大,又彼此成就,掌握了这套组合拳,你不仅能高效地解决各种规模的数据问题,更能在激烈的职业竞争中建立起难以被替代的核心壁垒,就从安装Python、注册Kaggle账号开始,踏上你的数据科学进阶之旅吧!

(文末可添加CTA,如:) 你对Python、Kaggle、Spark的学习有什么心得或疑问?欢迎在评论区留言讨论,我们一起交流进步!