urlparse 本身不负责下载,它的核心功能是解析 URL,但它是下载操作中至关重要的一步,因为它能帮你从复杂的 URL 字符串中提取出有用的信息,比如域名、路径、文件名等,从而构建正确的下载请求。

下面我将分步讲解,从解析 URL 到最终下载文件。

第一步:理解 urlparse 的作用

urllib.parse.urlparse() 函数可以将一个 URL 字符串解析成一个包含 6 个组件的命名元组,这 6 个组件分别是:

- scheme (协议): 如

http,https,ftp - netloc (网络位置): 如

www.example.com:8080 - path (路径): 如

/download/file.zip - params (参数): 较少使用,如

;key=value - query (查询字符串): 如

?user_id=123&token=abc - fragment (片段/锚点): 如

#section1

示例:

from urllib.parse import urlparse

url = "https://www.example.com:8080/download/archive.zip?v=1.2#intro"

parsed_url = urlparse(url)

print(f"原始 URL: {url}")

print(f"解析结果: {parsed_url}")

print("-" * 30)

print(f"协议 (scheme): {parsed_url.scheme}")

print(f"网络位置 (netloc): {parsed_url.netloc}")

print(f"路径 (path): {parsed_url.path}")

print(f"查询字符串 (query): {parsed_url.query}")

print(f"片段 (fragment): {parsed_url.fragment}")

输出:

原始 URL: https://www.example.com:8080/download/archive.zip?v=1.2#intro

解析结果: ParseResult(scheme='https', netloc='www.example.com:8080', path='/download/archive.zip', params='', query='v=1.2', fragment='intro')

------------------------------

协议 (scheme): https

网络位置 (netloc): www.example.com:8080

路径 (path): /download/archive.zip

查询字符串 (query): v=1.2

片段 (fragment): intro为什么这很重要?

在下载时,path 的最后一部分通常就是我们要下载的文件名,我们可以用它来命名本地保存的文件。

第二步:结合 urllib.request 下载文件

urllib.request 是 Python 标准库中用于打开和读取 URL 的模块,我们将使用 urlparse 获取的信息来构建一个稳健的下载器。

示例 1:下载并保存文件(基础版)

这个例子会下载一个文件,并使用 URL 中的路径作为文件名。

import urllib.request

from urllib.parse import urlparse

import os

def download_file(url, save_path=None):

"""

下载文件并保存到指定路径。

如果未提供 save_path,则从 URL 中提取文件名作为保存路径。

"""

try:

# 1. 解析 URL

parsed_url = urlparse(url)

# 2. 如果没有提供保存路径,则从 URL 的路径中提取文件名

if save_path is None:

# 获取路径的最后一部分,即文件名

file_name = os.path.basename(parsed_url.path)

if not file_name: # 如果路径以 / 可能没有文件名

file_name = "downloaded_file"

save_path = file_name

# 3. 发起下载请求

print(f"开始下载: {url}")

print(f"保存为: {save_path}")

# 使用 with 语句确保资源被正确关闭

with urllib.request.urlopen(url) as response, open(save_path, 'wb') as out_file:

# 将响应内容写入文件

out_file.write(response.read())

print("下载完成!")

return save_path

except urllib.error.URLError as e:

print(f"下载失败,URL 错误: {e.reason}")

except Exception as e:

print(f"发生未知错误: {e}")

# --- 使用示例 ---

file_url = "https://www.python.org/static/img/python-logo.png"

download_file(file_url)

运行结果:

脚本会在当前目录下创建一个名为 python-logo.png 的文件,并下载图片内容。

示例 2:更稳健的下载器(带进度条和错误处理)

在实际应用中,我们可能希望看到下载进度,并处理大文件,下面是一个更完善的版本。

import urllib.request

from urllib.parse import urlparse

import os

import shutil

def download_file_with_progress(url, save_path=None):

"""

带进度条的文件下载器。

"""

try:

# 1. 解析 URL

parsed_url = urlparse(url)

if save_path is None:

file_name = os.path.basename(parsed_url.path)

if not file_name:

file_name = "downloaded_file"

save_path = file_name

# 2. 获取文件大小以显示进度

with urllib.request.urlopen(url) as response:

file_size = int(response.headers.get('Content-Length', 0))

print(f"开始下载: {url}")

print(f"文件大小: {file_size / (1024*1024):.2f} MB")

# 3. 使用 shutil.copyfileobj 进行带进度的下载

with urllib.request.urlopen(url) as response, open(save_path, 'wb') as out_file:

downloaded = 0

# 每次读取 8KB 的数据

block_size = 8192

while True:

buffer = response.read(block_size)

if not buffer:

break

out_file.write(buffer)

downloaded += len(buffer)

# 显示进度

progress = (downloaded / file_size) * 100 if file_size > 0 else 0

print(f"\r进度: {progress:.2f}%", end="")

print("\n下载完成!")

return save_path

except urllib.error.URLError as e:

print(f"\n下载失败,URL 错误: {e.reason}")

except Exception as e:

print(f"\n发生未知错误: {e}")

# --- 使用示例 ---

# 下载一个较大的文件,例如一个 Python 安装包

large_file_url = "https://www.python.org/ftp/python/3.11.0/Python-3.11.0.tgz"

download_file_with_progress(large_file_url, "python-3.11.0.tgz")

运行结果: 你会看到一个动态更新的进度条,直到下载完成。

第三步:处理更复杂的情况(带查询参数)

下载链接的真实文件名并不在 path 中,而是在查询字符串(query)里。http://example.com/get?file_id=123&name=my_document.pdf。

在这种情况下,我们需要从 query 参数中解析出文件名。

from urllib.parse import urlparse, parse_qs

import urllib.request

def download_with_query_filename(url):

"""

从查询字符串中提取文件名并进行下载。

"""

try:

parsed_url = urlparse(url)

# 解析查询字符串

query_params = parse_qs(parsed_url.query)

# 假设文件名在 'name' 参数中

file_name = query_params.get('name', [None])[0]

if file_name:

save_path = file_name

else:

# 如果找不到,则使用默认方式

save_path = os.path.basename(parsed_url.path) or "downloaded_file"

print(f"下载链接: {url}")

print(f"解析出的文件名: {save_path}")

with urllib.request.urlopen(url) as response, open(save_path, 'wb') as out_file:

out_file.write(response.read())

print("下载完成!")

return save_path

except Exception as e:

print(f"下载失败: {e}")

# --- 使用示例 ---

# 这是一个假设的 URL

query_url = "https://example.com/api/download?user_id=987&filename=data_report.csv&token=xyz"

download_with_query_filename(query_url)

这个脚本会尝试从 filename=data_report.csv 中提取出 data_report.csv 作为保存的文件名。

总结与最佳实践

- 职责分离:

urlparse负责解析,urllib.request负责请求和下载,它们是协同工作的关系。 - 提取文件名:

os.path.basename(urlparse(url).path)是从 URL 路径获取文件名的最常用方法。 - 处理错误:下载操作网络不稳定,一定要使用

try...except来捕获urllib.error.URLError等异常。 - 二进制模式:下载文件时,务必使用

'wb'(write binary) 模式打开文件,以防止文件内容被错误地编码。 - 流式下载:对于大文件,不要一次性读取

response.read()到内存,而应使用shutil.copyfileobj或循环读取小块数据(如示例2),这样可以节省内存并显示进度。 - 更现代的选择:虽然

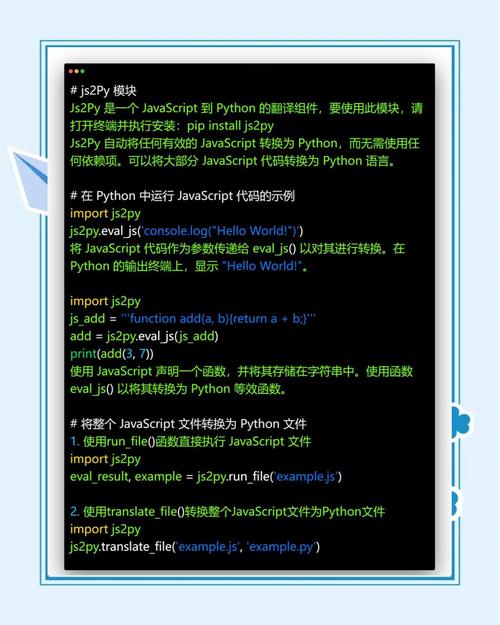

urllib是标准库,但对于更复杂的网络请求(如处理 Cookies、Session、POST 数据等),requests库是更流行、更易用的选择。requests内部也处理了 URL 解析,但如果你需要手动处理,urlparse依然是你的利器。

希望这个详细的教程能帮助你理解和使用 Python 的 urlparse 和 urllib 进行文件下载!