Python 处理 Unicode 完全指南:从 parseunicodez 到最佳实践

告别乱码,彻底搞懂 Python 中的 Unicode 编码、解码与高级文本处理

(Meta Description)

还在为 Python 中的 Unicode 编码问题头疼吗?本文深入探讨 Python 的 Unicode 处理机制,即使是面对类似 parseunicodez 这样的特定需求,也能提供清晰的解决方案,从基础的 encode()/decode() 到高级的 surrogate 处理,助你成为 Python 文本处理专家,轻松解决所有乱码难题。

引言:当“乱码”不期而至

每一位 Python 开发者都曾遇到过这样的场景:从网页抓取的文本显示成 â€TM,读取的 CSV 文件内容一团乱码,或者在不同系统间传输数据时出现 UnicodeDecodeError,这些问题的根源,往往都指向同一个核心概念——Unicode。

你可能在网上搜索过类似 “python 解析 unicodez” 或 “python 处理特殊编码” 的关键词,比如今天我们的核心词 python parseunicodez,虽然 parseunicodez 并不是一个 Python 内置的函数或标准库,但它很可能代表了你内心深处的一个具体需求:“我该如何用 Python 解析、处理那些包含特殊 Unicode 字符或非标准编码格式的文本?”

本文将不再让你面对这些模糊的搜索词感到困惑,我们将系统地、由浅入深地拆解 Python 的 Unicode 世界,不仅告诉你“怎么做”,更让你明白“为什么”,最终让你能够自信地处理任何文本数据。

第一章:理解 Unicode 的本质——不只是“字符集”

在动手写代码之前,我们必须建立正确的认知。

1 ASCII vs. Unicode

- ASCII:早期的编码标准,只能表示 128 个英文字符,无法满足全球多语言的需求,一个字节表示一个字符。

- Unicode:一个旨在容纳全世界所有字符和符号的字符集,它是一个“字典”,为每个字符分配了一个唯一的数字,称为 码点。

关键点:Unicode 本身只是一种“映射关系”,它规定了字符和码点的一一对应,但并没有规定如何存储这个码点。

2 Unicode 的“变身”——UTF-8, UTF-16, UTF-32

为了让 Unicode 能够在计算机中存储和传输,人们设计了多种编码方案,其中最常见的是 UTF-8。

-

UTF-8 (Unicode Transformation Format - 8-bit):

- 变长编码:它可以用 1 到 4 个字节来表示一个字符。

- 兼容 ASCII:对于英文字符,UTF-8 使用 1 个字节,且与 ASCII 编码完全相同,这是它在互联网上占据主导地位的原因。

- 无 BOM:通常不需要字节顺序标记,跨平台性好。

-

UTF-16:

(图片来源网络,侵删)

(图片来源网络,侵删)- 变长编码:通常使用 2 个字节表示一个字符,对于某些辅助平面字符(如 Emoji)则使用 4 个字节。

- 有 BOM:在 Windows 系统上,UTF-16 文件通常以 BOM 开头,用于标识字节序。

-

UTF-32:

- 定长编码:始终使用 4 个字节表示一个字符。

- 空间浪费:处理纯英文文本时,会浪费大量空间,因此不常用。

在 Python 开发中,强烈推荐使用 UTF-8 作为默认的编码格式。

第二章:Python 3 的 Unicode 之道——“字符串即 Unicode”

Python 3 在设计上做出了一个里程碑式的决定:所有字符串(str 类型)在内存中都以 Unicode 码点序列的形式存在。

这意味着,当你写下 s = "你好,世界!" 时,变量 s 并不是存储了字节,而是存储了这些字符对应的 Unicode 码点。

这就引出了 Python 3 中两个核心的概念:

- 字符串:内存中的 Unicode 序列,类型为

str。 - 字节串:磁盘或网络传输中的二进制数据,类型为

bytes。

str 和 bytes 是两种完全不同的类型,不能直接拼接或比较,它们之间的桥梁就是 编码 和 解码。

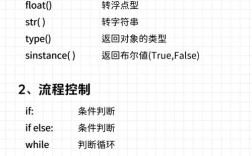

1 编码与解码:Unicode 与字节世界的对话

-

编码:将

str(Unicode 字符串) 转换为bytes(字节串) 的过程。- 使用字符串的

.encode()方法。 s.encode('utf-8'):将字符串s按照 UTF-8 规则编码成字节。

- 使用字符串的

-

解码:将

bytes(字节串) 转换为str(Unicode 字符串) 的过程。- 使用字节串的

.decode()方法。 b_data.decode('utf-8'):将字节串b_data按照 UTF-8 规则解码成字符串。

- 使用字节串的

代码示例:

# 一个包含中文字符的字符串

my_string = "Python 是一门强大的语言"

# 1. 编码:将 str 转换为 bytes

# 我们使用最常用的 UTF-8 编码

my_bytes_utf8 = my_string.encode('utf-8')

print(f"原始字符串: {my_string}")

print(f"UTF-8 编码后的字节串: {my_bytes_utf8}")

# 输出: b'Python \xe6\x98\xaf\xe4\xb8\x80\xe9\x97\xa8\xe5\xbc\xba\xe5\xa4\xa7\xe7\x9a\x84\xe8\xaf\xad\xe8\xa8\x80'

# 2. 解码:将 bytes 转换回 str

# 使用相同的编码格式进行解码

decoded_string = my_bytes_utf8.decode('utf-8')

print(f"解码后的字符串: {decoded_string}")

# 输出: Python 是一门强大的语言

# --- 错误处理 ---

# 如果编码和解码的格式不一致,会抛出 UnicodeDecodeError

try:

# 尝试用 gbk 解码 utf-8 编码的字节串

my_bytes_utf8.decode('gbk')

except UnicodeDecodeError as e:

print(f"\n错误捕获: {e}")

# 输出: 错误捕获: 'gbk' codec can't decode byte 0xe6 in position 7: incomplete multibyte sequence

第三章:实战演练——解决 parseunicodez 式的难题

我们回到最初的问题。parseunicodez 可能代表以下几种常见场景,我们将逐一攻克。

处理来自文件或网络的未知编码数据

这是最常见的问题,你拿到的数据不知道是什么编码,直接读取就会报错。

解决方案:使用 chardet 库自动检测编码。

chardet 是一个强大的第三方库,可以分析字节数据并猜测其最可能的编码。

安装:

pip install chardet

代码示例:

import chardet

# 假设我们有一个从网络下载或文件读取的字节串

# 这里我们手动创建一个以 GBK 编码的字节串

unknown_bytes = "这是GBK编码的文本".encode('gbk')

# 1. 使用 chardet 检测编码

result = chardet.detect(unknown_bytes)

encoding = result['encoding']

confidence = result['confidence']

print(f"检测到的编码: {encoding}, 置信度: {confidence}")

# 2. 使用检测到的编码进行解码

if confidence > 0.9: # 设置一个置信度阈值

decoded_text = unknown_bytes.decode(encoding)

print(f"成功解码: {decoded_text}")

else:

print("置信度过低,无法确定编码。")

# --- 模拟从文件读取 ---

# with open('unknown_encoding_file.txt', 'rb') as f:

# raw_data = f.read()

# detected_encoding = chardet.detect(raw_data)['encoding']

# text = raw_data.decode(detected_encoding or 'utf-8', errors='ignore')

# print(text)

处理含有“代理对”(Surrogate Pairs)的 Unicode 字符

有些 Unicode 字符,特别是 Emoji 表情符号(如 😊, 🚀)和一些罕见符号,它们的码点超过了 0xFFFF,在 UTF-16 编码中,这类字符需要用两个 16 位的“代理单元”(Surrogate Code Units)来表示,即“代理对”。

在 Python 中,当你处理这些字符时,可能会遇到 str 类型内部使用“代理对”表示的情况,了解这一点对于深度解析文本至关重要。

代码示例:

# 一个包含 Emoji 的字符串