如何获取《Python网络数据采集》中文PDF

这本书的英文原版是 "Web Scraping with Python" by Ryan Mitchell,中文版由人民邮电出版社出版,书名即为 《Python网络数据采集》。

以下是获取PDF的几种主要途径,请根据你的需求和版权意识进行选择:

官方正版渠道(推荐)

这是最合法、最支持作者和出版社的方式。

- 购买电子书:国内主流的电子书平台通常都有销售。

- 京东读书:搜索“Python网络数据采集”,可以购买正版电子书,通常也支持下载为PDF格式。

- 当当云阅读:与京东类似,是另一个购买电子书的热门平台。

- 得到App / Kindle中国商店:如果你习惯在这些平台阅读,也可以搜索购买。

- 购买实体书:

- 当当网 / 京东图书:可以购买实体书,很多商家会随书赠送电子版(包括PDF),或者你可以自己扫描实体书制作PDF,这是获取高质量PDF的绝佳方式。

非官方渠道(需注意版权和风险)

在网络上搜索时,你可能会找到一些免费分享的PDF资源。这些资源大多属于盗版,可能存在以下问题:

- 质量参差不齐:可能是低质量的扫描版,文字模糊、排版错乱。

- 内容不完整:可能缺少章节、附录或代码。

- 安全风险:下载链接可能包含病毒或恶意软件。

- 法律风险:传播和下载盗版内容是侵犯作者和出版社合法权益的行为。

如果你仍然希望寻找这些资源,可以尝试在以下平台使用关键词搜索:

- 搜索引擎:使用

Python网络数据采集 pdf site:pan.baidu.com或Python网络数据采集 pdf site:zhuanlan.zhihu.com等组合进行搜索。 - 文件分享网站:如百度网盘、阿里云盘等。

- 技术社区:如知乎、CSDN、GitHub的一些仓库中可能会有读者分享的笔记或资源。

强烈建议:为了获得最佳阅读体验、支持作者创作以及保护自身设备安全,优先选择官方正版渠道。

这本书的核心内容概览

无论你通过何种方式获取,了解这本书的核心内容将帮助你更好地学习,这本书是Python网络爬虫领域的“圣经”级入门读物。

全书结构清晰,循序渐进:

-

第一部分:基础准备

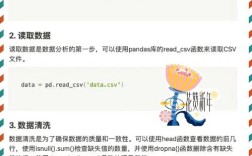

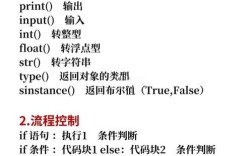

(图片来源网络,侵删)

(图片来源网络,侵删)- 介绍网络数据采集的基本概念、法律和道德规范。

- 搭建Python环境,并讲解爬虫依赖的核心库:

requests、Beautiful Soup、lxml。

-

第二部分:核心爬虫技术

- 第2章:第一个网络爬虫:使用

urllib和正则表达式进行简单的网页抓取和解析,这是最基础的方法。 - 第3章:使用Beautiful Soup进行解析:详细讲解如何使用Beautiful Soup这个强大的HTML/XML解析库,它比正则表达式更健壮、更易用。

- 第4章:使用网络爬虫采集数据:结合

requests和Beautiful Soup,构建一个完整的爬虫项目,抓取并保存数据(如CSV、Excel文件)。 - 第5章:存储数据:介绍如何将抓取的数据存储到数据库中,如

SQLite、MySQL、MongoDB等。

- 第2章:第一个网络爬虫:使用

-

第三部分:进阶与高级主题

- 第6章:读取文档:讲解如何处理非HTML格式的数据,如PDF、Word、Excel等。

- 第7章:处理登录和cookies:模拟用户登录,处理会话和认证问题。

- 第8章:处理JavaScript:当网页内容由JavaScript动态生成时,简单的

requests请求无法获取数据,本章介绍解决方案,如使用Selenium或Splash来控制浏览器或渲染页面。 - 第9章:爬虫的伦理与法律:深入探讨爬虫的“红线”,如何尊重

robots.txt协议,避免对服务器造成过大压力,以及相关的法律法规。 - 第10章:爬虫的测试与调试:如何让你的爬虫更稳定、更高效。

- 第11章:使用Scrapy进行爬取:介绍Scrapy这个功能强大的爬虫框架,适合构建大型、复杂的爬虫项目。

- 第12章:分布式爬虫:讲解如何使用Scrapy-Redis等技术,将爬虫任务分布到多台机器上执行,提高抓取效率。

学习建议

- 动手实践,而非只看不练:这本书最大的特点是代码示例丰富。务必将书中的每一个例子都亲手敲一遍、运行一遍,并尝试修改代码,观察结果变化。

- 环境搭建要细心:确保你的Python环境和所有依赖库(

requests,beautifulsoup4,lxml,selenium等)都正确安装,遇到问题善用搜索引擎(如Google、百度)和Stack Overflow。 - 从简单到复杂:严格按照书的顺序学习,先掌握

requests和Beautiful Soup,这是爬虫的基石,再挑战Selenium处理动态页面,最后学习Scrapy框架。 - 培养“爬虫思维”:学习爬虫不仅仅是学API,更是学习分析目标网站的结构,学会使用浏览器的“开发者工具”(F12)来检查网页元素、查看网络请求,这是爬虫工程师的核心技能。

- 关注“礼貌”爬虫:认真阅读第9章,一个优秀的爬虫工程师必须懂得如何控制爬取频率、设置请求头、遵守

robots.txt,做一个“有礼貌”的访问者。

希望这份详细的指南能帮助你顺利找到并学好这本经典的《Python网络数据采集》!祝你学习愉快!