“伟岸”这个词用在这里非常贴切,Python自然语言处理,尤其是以大型语言模型(LLM)为代表的现代NLP,确实是人工智能领域一座伟岸的山峰,它正在以前所未有的深度和广度,重塑我们的世界。

下面我将从几个方面,为您系统地梳理Python NLP的知识体系、核心技术和实践路径。

为什么Python是NLP的“王者”?

在开始之前,我们必须明白为什么Python是NLP领域当之无愧的霸主。

- 丰富的生态系统:Python拥有大量专门为NLP设计的库和框架,从底层的文本处理到顶层的模型应用,应有尽有。

- 易学易用:Python语法简洁,上手快,让研究人员和工程师可以专注于算法和逻辑,而不是复杂的编程细节。

- 强大的社区支持:无论是遇到问题还是寻找最新技术,你都能在庞大的Python社区中找到答案和帮助。

- 学术与工业界的桥梁:Python是学术研究(尤其是在AI领域)最常用的语言,这使得前沿成果能快速转化为工业界的工具和产品。

Python NLP的核心工具箱(“利器”)

要攀登NLP这座“伟岸”的高山,你需要一套精良的工具,以下是每个Python NLP从业者必须掌握的库:

基础文本处理库

- NLTK (Natural Language Toolkit):NLP领域的“元老”,功能全面,非常适合学习和理解NLP的基础概念(如分词、词性标注、句法分析等),它像一本百科全书,包含了大量的语料库和算法。

- spaCy:工业界的宠儿,它的特点是速度快、效率高、易于集成,spaCy提供了预训练的、针对特定语言优化的模型,能直接用于生产环境,处理大规模文本数据。

对比:

- NLTK:像实验室,适合学习和实验。

- spaCy:像工厂,适合快速构建应用。

文本表示与向量化

计算机无法直接理解文本,必须将其转换为数字(向量),这是所有机器学习和深度学习模型的基础。

- Scikit-learn:提供了经典的机器学习算法和文本向量化工具,如

CountVectorizer(词袋模型) 和TfidfVectorizer(TF-IDF)。 - Gensim:专注于主题建模和文档相似度计算,其

Word2Vec模型是词嵌入的开创性工作之一。 - Transformers (Hugging Face):这是当前最核心、最伟岸的库,它使得使用像BERT、GPT、T5这样最先进的预训练模型变得极其简单,你可以轻松地将文本转换为上下文相关的、高质量的向量表示。

深度学习框架

这些是构建和训练现代NLP模型(如RNN, LSTM, Transformer)的引擎。

- TensorFlow (with Keras):由Google开发,生态系统强大,部署灵活。

- PyTorch:由Facebook开发,以其动态计算图和“Pythonic”的风格在学术界和研究者中广受欢迎,是目前研究和开发新模型的主流选择。

大型语言模型与生成式AI

这是当前NLP领域最“伟岸”的浪潮,以ChatGPT为代表。

- LangChain:一个强大的框架,用于将LLM(如OpenAI的GPT系列)与外部数据源(数据库、API)和工具结合起来,构建复杂的、基于知识的应用程序(如智能问答、文档摘要等)。

- LlamaIndex:专注于解决LLM与私有数据连接的问题,让LLM能够“阅读”和“理解”你自己的文档(如PDF、Word、数据库),并进行精准回答。

Python NLP的典型应用场景(“伟岸”的用武之地)

Python NLP的“伟岸”之处在于它无处不在的应用:

- 智能客服与聊天机器人:理解用户意图,自动回答常见问题,提供7x24小时服务。

- 搜索引擎与推荐系统:理解你的搜索查询,返回最相关的结果;根据你的兴趣推荐新闻、商品、视频。

- 情感分析与舆情监控:分析社交媒体、电商评论中的用户情感,帮助企业了解品牌口碑和市场反馈。

- 机器翻译:将一种语言自动翻译成另一种语言,打破语言壁垒。

- 内容自动生成:自动撰写新闻稿、营销文案、代码、邮件等。

- 智能文档处理:从合同、简历、发票等非结构化文档中自动提取关键信息(如姓名、日期、金额)。

- 法律与医疗文本分析:从海量案例中找出关键判例,从病历中提取诊断信息。

学习与实践路径(如何攀登这座“伟岸”的高山)

对于初学者,建议按照以下循序渐进的路径学习:

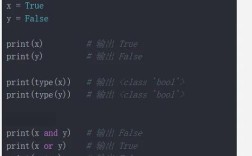

打好基础

- 精通Python:熟悉基本语法、数据结构(列表、字典)、函数和类。

- 学习NLP基础理论:

- 文本预处理:分词、去除停用词、词干提取/词形还原。

- 文本表示:词袋模型、TF-IDF。

- 基础机器学习:了解分类、聚类等概念,并使用

scikit-learn实践一个简单的文本分类任务(如垃圾邮件检测)。

推荐资源:

- 书籍:《Python自然语言处理》(NLTK官方书籍)

- 在线课程:Coursera上的 "Natural Language Processing" 专项课程

进阶实战

- 掌握spaCy:学习如何使用spaCy进行高效的实体识别、词性标注和依存句法分析。

- 学习词嵌入:使用

gensim训练Word2Vec模型,理解词语之间的语义关系。 - 入门深度学习:学习

PyTorch或TensorFlow,并了解RNN、LSTM等基础序列模型。

推荐资源:

- spaCy官方文档和教程

- fast.ai 课程(非常注重实践)

拥抱前沿(登顶“伟岸”之巅)

- 掌握Transformers库:这是最重要的一步,学习如何使用

Hugging Face Transformers加载预训练模型(如BERT、RoBERTa)进行文本分类、问答、摘要等任务。 - 学习大型语言模型的应用:

- 掌握

LangChain或LlamaIndex,学习如何构建基于LLM的RAG(检索增强生成)应用,这是当前工业界最热门的技术之一。 - 学习如何使用OpenAI API、Anthropic Claude API等。

- 掌握

- 探索微调:学习如何在自己的数据集上微调预训练模型,以适应特定领域的任务。

推荐资源:

- Hugging Face官方课程和文档

- 《Build a Large Language Model (From Scratch)》书籍

- 大量关注技术博客和GitHub上的开源项目。

代码示例:从简单到“伟岸”

示例1:使用spaCy进行基础NLP任务

import spacy

# 加载英文模型

nlp = spacy.load("en_core_web_sm")

text = "Apple is looking at buying a U.K. startup for $1 billion. It's a great deal."

# 处理文本

doc = nlp(text)

# 1. 分词

print("Tokens:")

for token in doc:

print(token.text)

# 2. 词性标注和命名实体识别

print("\nPOS Tags & Entities:")

for token in doc:

print(f"{token.text:<12} {token.pos_:<8} {token.ent_type_}")

# 3. 实体识别

print("\nNamed Entities:")

for ent in doc.ents:

print(f"{ent.text:<15} {ent.label_:<10} {spacy.explain(ent.label_)}")

示例2:使用Hugging Face Transformers进行情感分析(“伟岸”的力量)

from transformers import pipeline

# 使用预训练的情感分析模型,pipeline会自动下载模型

classifier = pipeline("sentiment-analysis")

results = classifier([

"I've been waiting for a HuggingFace course my whole life.",

"I hate this so much!"

])

print(results)

# 输出:

# [{'label': 'POSITIVE', 'score': 0.9998},

# {'label': 'NEGATIVE', 'score': 0.9991}]

看到了吗?仅仅三行代码,我们就使用了最先进的模型完成了复杂的任务,这就是Python NLP“伟岸”之处——将复杂的技术封装得如此简单易用。

Python自然语言处理是一座伟岸的技术高峰,它既有NLTK、spaCy这样坚实的地基,也有Transformers、LangChain这样直插云霄的塔尖,它不仅是技术的集合,更是连接人类语言与机器智能的桥梁。

无论你是想成为一名数据科学家、机器学习工程师,还是对AI充满好奇的探索者,学习Python NLP都将为你打开一扇通往未来的大门,从基础开始,一步一个脚印,你终将能领略到这座“伟岸”山峰的无限风光。