Python语义相似性终极指南:从入门到精通,轻松实现文本智能“读懂”人心

Meta Description (用于百度搜索结果摘要):

想用Python让机器“理解”文本?本文深入浅出讲解Python语义相似性技术,从TF-IDF到BERT,提供完整代码示例,助你轻松掌握文本智能核心,实现精准文本匹配与搜索。

引言:不止是“字面”相同,更是“语义”相通

作为一名程序员,我们每天都在与数据打交道,其中文本数据占据了相当大的比重,你是否曾遇到过这样的问题:

- 如何在成千上万条用户评论中,快速找出所有对“电池续航”表达不满的句子?(电量太不耐用了”、“半天就没电了”)

- 如何让推荐系统更智能,知道“笔记本电脑”和“手提电脑”其实是同一个东西?

- 如何构建一个智能客服,能准确识别用户问题的核心意图,而不是仅仅匹配关键词?

传统的关键词匹配(如TF-IDF)在这里显得力不从心,因为它无法理解词语背后的深层含义。这就是Python语义相似性技术大显身手的地方。

本文将作为你的终极指南,带你从零开始,系统性地学习和掌握如何使用Python计算文本的语义相似性,让你的程序真正“读懂”文字背后的意义。

什么是语义相似性?为什么它如此重要?

语义相似性 是衡量两段文本在意义上“有多像”的指标,它与“关键词相似性”相对,后者只关心词语是否重合。

-

关键词相似性低,语义相似性高的例子:

- 文本A:“这家餐厅的菜品味道非常出色。”

- 文本B:“我在这家饭馆吃到了美味的食物。”

- 分析: 它们没有共同的“关键词”,但表达的是完全相同的“语义”——食物好吃。

-

关键词相似性高,语义相似性低的例子:

- 文本A:“苹果公司的产品生态非常完善。”

- 文本B:“我今天吃了一个苹果,很甜。”

- 分析: 它们都包含“苹果”,但“语义”却天差地别。

重要性不言而喻:

- 搜索引擎优化: 提供更精准的搜索结果,理解用户的真实查询意图。

- 推荐系统: 推荐内容更符合用户兴趣,提升用户体验。

- 智能客服与聊天机器人: 准确识别用户问题,提供更有效的回答。

- 文本聚类与分类: 自动将有意义的文本组织在一起。

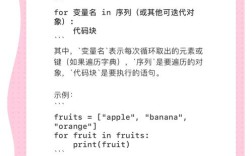

Python实现语义相似性的三大主流技术

我们将从简单到复杂,介绍三种目前最主流的Python实现方法。

基于词向量的经典方法 - Word2Vec / GloVe

这是语义相似性领域的里程碑式技术,它的核心思想是:“上下文相似的词,其向量表示也相似”。

工作原理:

- 训练/加载词向量模型: 通过大量语料库训练,为每个词语生成一个高维(如300维)的向量,这个向量捕捉了该词语的语法和语义信息。

- 文本向量化: 将两段文本中的所有词向量进行平均(或使用更复杂的方法如TF-IDF加权平均),得到两个代表整段文本的向量。

- 计算向量相似度: 使用余弦相似度来计算这两个文本向量的夹角,夹角越小,余弦值越接近1,代表语义越相似。

Python实战 (使用 gensim 库):

# 安装依赖

# pip install gensim nltk

import nltk

from nltk.corpus import stopwords

from nltk.tokenize import word_tokenize

from gensim.models import Word2Vec

from sklearn.metrics.pairwise import cosine_similarity

import numpy as np

# 下载nltk数据(只需一次)

nltk.download('punkt')

nltk.download('stopwords')

# 示例语料库(实际应用中需要海量数据)

sentences = [

["the", "king", "is", "royal"],

["the", "queen", "is", "royal"],

["man", "and", "woman", "are", "human"],

["boy", "and", "girl", "are", "human"],

["apple", "is", "a", "fruit"],

["banana", "is", "a", "fruit"]

]

# 1. 训练Word2Vec模型

model = Word2Vec(sentences, vector_size=100, window=5, min_count=1, workers=4)

# 2. 定义一个函数,将句子转换为向量(平均词向量)

def sentence_to_vector(sentence, model):

words = word_tokenize(sentence.lower())

words = [w for w in words if w not in stopwords.words('english')]

vectors = [model.wv[w] for w in words if w in model.wv]

if not vectors:

return np.zeros(model.vector_size)

return np.mean(vectors, axis=0)

# 3. 计算两个句子的语义相似度

sentence1 = "the king is powerful"

sentence2 = "the queen is majestic"

vec1 = sentence_to_vector(sentence1, model)

vec2 = sentence_to_vector(sentence2, model)

similarity = cosine_similarity([vec1], [vec2])[0][0]

print(f"句子1: '{sentence1}'")

print(f"句子2: '{sentence2}'")

print(f"Word2Vec语义相似度: {similarity:.4f}")

# 输出会是一个接近1的值,因为"king"和"queen"的向量很相似

优缺点:

- 优点: 概念清晰,能捕捉一定的词语间关系(如

向量(“国王”) - 向量(“男人”) + 向量(“女人”) ≈ 向量(“女王”))。 - 缺点: 无法处理一词多义,且简单的词平均会丢失句子结构和顺序信息。

基于上下文的进阶方法 - FastText

FastText是Word2Vec的改进版,由Facebook推出,它最大的不同是:将词语看作字符n-gram的集合。

“apple”会被拆分为 <app, app<, appl, ppl<, pple, ple> 等子词。

Python实战 (使用 gensim 库):

使用方法与Word2Vec几乎完全相同,只需将 Word2Vec 替换为 FastText。

from gensim.models import FastText

# 1. 训练FastText模型

fasttext_model = FastText(sentences, vector_size=100, window=5, min_count=1, workers=4)

# 2. 和Word2Vec一样,计算句子向量

vec1_fast = sentence_to_vector(sentence1, fasttext_model)

vec2_fast = sentence_to_vector(sentence2, fasttext_model)

similarity_fast = cosine_similarity([vec1_fast], [vec2_fast])[0][0]

print(f"\nFastText语义相似度: {similarity_fast:.4f}")

优缺点:

- 优点: 能很好地处理未登录词(OOV, Out-of-Vocabulary),因为即使一个词没见过,它的子词组合可能见过,对词形变化(复数、时态)更鲁棒。

- 缺点: 仍然无法完美解决一词多义问题,且句子向量化方法依然简单。

基于深度学习的革命性方法 - BERT / Sentence-BERT

这是目前效果最好的方法,由Google(BERT)和德国研究者(Sentence-BERT, SBERT)提出,它的革命性在于:真正理解上下文,并能直接生成高质量的句子向量。

工作原理:

- 预训练模型: BERT在海量文本上进行了预训练,学习了深度的语言表示,它能根据上下文确定一个词的含义(解决一词多义)。

- 微调/直接使用: 我们可以直接加载一个预训练好的BERT模型(如

bert-base-chinese或bert-base-uncased),对于句子相似性任务,最常用的是 Sentence-BERT (SBERT),它专门修改了BERT的结构,使其能高效地生成固定长度的、质量极高的句子向量。 - 计算向量相似度: 同样使用余弦相似度计算SBERT生成的句子向量。

Python实战 (使用 sentence-transformers 库):

# 安装依赖

# pip install sentence-transformers

from sentence_transformers import SentenceTransformer, util

import torch

# 1. 加载一个预训练的SBERT模型(这里使用一个轻量且效果好的模型)

model = SentenceTransformer('all-MiniLM-L6-v2')

# 2. 定义要比较的句子对

sentences = [

"The cat sits on the mat.",

"A feline is resting on the rug.",

"The dog plays in the garden.",

"A canine is frolicking in the yard.",

"The car is red.",

"The automobile is crimson."

]

# 3. 将所有句子转换为向量

embeddings = model.encode(sentences, convert_to_tensor=True)

# 4. 计算句子之间的余弦相似度矩阵

cosine_scores = util.cos_sim(embeddings, embeddings)

# 5. 打印相似度矩阵

print("\n--- SBERT 语义相似度矩阵 ---")

for i in range(len(sentences)):

for j in range(len(sentences)):

print(f"{i+1}. '{sentences[i]}' vs {j+1}. '{sentences[j]}': {cosine_scores[i][j].item():.4f}")

# 为了更直观,我们只比较特定句子对

sentence_pair_1 = ["The cat sits on the mat.", "A feline is resting on the rug."]

sentence_pair_2 = ["The cat sits on the mat.", "The dog plays in the garden."]

emb1 = model.encode(sentence_pair_1[0], convert_to_tensor=True)

emb2 = model.encode(sentence_pair_1[1], convert_to_tensor=True)

sim_pair_1 = util.cos_sim(emb1, emb2).item()

emb1_p2 = model.encode(sentence_pair_2[0], convert_to_tensor=True)

emb2_p2 = model.encode(sentence_pair_2[1], convert_to_tensor=True)

sim_pair_2 = util.cos_sim(emb1_p2, emb2_p2).item()

print(f"\nSBERT相似度:")

print(f"'{sentence_pair_1[0]}' vs '{sentence_pair_1[1]}': {sim_pair_1:.4f}") # 应该很高

print(f"'{sentence_pair_2[0]}' vs '{sentence_pair_2[1]}': {sim_pair_2:.4f}") # 应该很低

优缺点:

- 优点: 效果最好,能深刻理解上下文和语法结构,生成的句子向量质量极高,是目前工业界和学术界的首选。

- 缺点: 模型较大,计算资源消耗相对较高,推理速度比前两种方法慢。

技术选型:我该用哪一种?

| 技术 | 原理 | 优点 | 缺点 | 适用场景 |

|---|---|---|---|---|

| Word2Vec/GloVe | 词向量平均 | 简单、快速、概念易懂 | 无法处理一词多义、忽略上下文、无法处理OOV词 | 快速原型、资源受限环境、对精度要求不高的任务 |

| FastText | 子词向量 | 能处理OOV词、对词形变化鲁棒 | 仍无法完美解决一词多义 | 需要处理大量新词或拼写错误的场景,如社交媒体分析 |

| BERT/SBERT | 深度上下文表示 | 效果最佳、理解能力强、精度高 | 模型大、计算成本高、速度慢 | 对精度要求高的核心业务,如搜索引擎、智能问答、推荐系统 |

一句话总结:

- 想快速入门或做个小Demo?用 Word2Vec。

- 你的文本有很多新词或错别字?试试 FastText。

- 追求极致效果,不差钱也不差算力?直接上 SBERT,它不会让你失望。

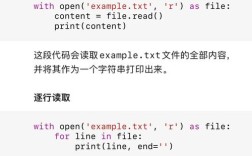

实战应用:构建一个简单的语义搜索引擎

假设我们有一个产品描述库,用户输入一个查询,我们想找到最相关的产品。

# 接续上面的SBERT代码

# 产品库

product_descriptions = [

"一款高性能的笔记本电脑,配备最新的M2芯片和16GB内存。",

"轻薄便携的超级本,续航长达12小时,适合商务出行。",

"专业游戏本,拥有强大的RTX 4070显卡和144Hz高刷屏。",

"入门级台式机,性价比之选,适合日常办公和影音娱乐。",

"设计精美的机械键盘,青轴手感,RGB背光。",

"人体工学鼠标,无线连接,有效减少手腕疲劳。"

]

# 用户查询

user_query = "我想要一台能玩游戏的电脑"

# 1. 对查询和所有产品描述进行向量化

query_embedding = model.encode(user_query, convert_to_tensor=True)

product_embeddings = model.encode(product_descriptions, convert_to_tensor=True)

# 2. 计算查询与每个产品描述的相似度

cosine_scores = util.cos_sim(query_embedding, product_embeddings)[0]

# 3. 将相似度分数与产品描述配对并排序

results = []

for score, desc in zip(cosine_scores, product_descriptions):

results.append((score.item(), desc))

# 按相似度降序排序

results.sort(key=lambda x: x[0], reverse=True)

# 4. 打印最相关的Top 3结果

print(f"\n--- 针对 '{user_query}' 的语义搜索结果 ---")

for i, (score, desc) in enumerate(results[:3]):

print(f"匹配度 {i+1}: {score:.4f}\n描述: {desc}\n")

运行结果会清晰地显示,与“玩游戏”最相关的产品是“专业游戏本”,其次是“高性能笔记本电脑”,这完全符合我们的语义直觉。

总结与展望

我们系统地走过了Python语义相似性的演进之路:从基础的词向量到革命性的深度学习模型。

-

核心要点回顾:

- 语义相似性让机器“理解”文本,而非仅仅“匹配”。

- Word2Vec/FastText是优秀的词向量工具,而BERT/SBERT则是当前句子级语义理解的王者。

- SBERT 因其卓越的性能和易用性,已成为大多数语义相似性任务的首选方案。

-

未来展望: 语义相似性技术仍在飞速发展,我们可以期待:

- 更高效的模型: 在保持精度的同时,模型体积更小、速度更快(如知识蒸馏、量化技术)。

- 多模态融合: 结合文本、图像、声音等多种信息进行综合语义理解。

- 更强的推理能力: 模型不仅能计算相似度,还能进行复杂的逻辑推理。

作为一名程序员,掌握Python语义相似性技术,意味着你拥有了构建更智能、更人性化的应用的核心能力,希望这篇指南能为你打开一扇新世界的大门,快去动手实践,让你的代码真正“读懂”人心吧!

参考资料与延伸阅读

- Sentence-Transformers 官方文档

- Google AI Blog - BERT

- Gensim 官方文档

- 《自然语言处理入门》—— 何晗 著