下面我将为你提供几种方法,从最推荐到特定场景下的解决方案,并详细解释其原理。

核心概念

-

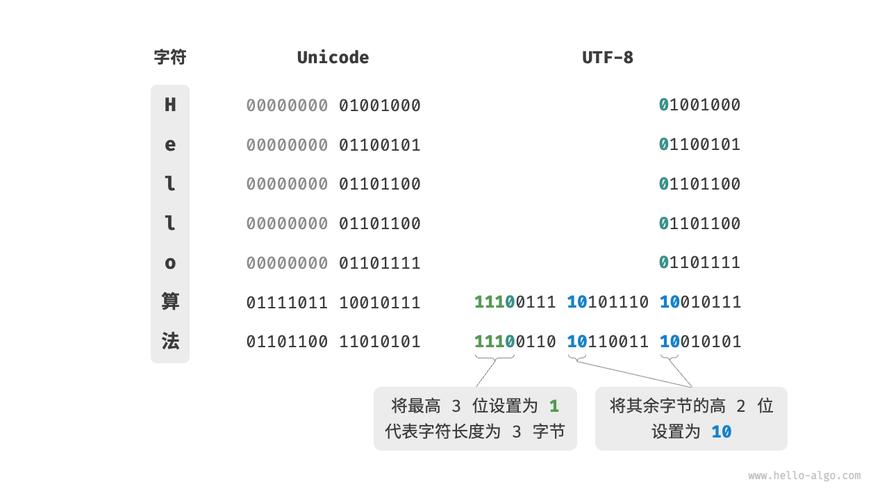

ANSI 不是一种固定的编码:在 Windows 环境下,“ANSI” 是一个模糊的术语,它通常指代系统的默认代码页,在中国大陆的 Windows 系统上,这个默认代码页几乎总是

GBK,在英文系统上,它通常是Windows-1252,要正确转换,关键在于确定原始文本究竟使用了哪种编码。 -

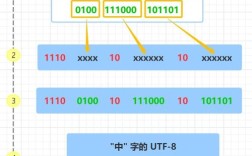

Python 3 的字符串:在 Python 3 中,字符串(

str类型)默认就是 Unicode 编码,当你读取一个文件时,如果指定了正确的编码(如gbk),Python 会自动将其解码成内部的 Unicode 字符串,当你写入文件时,如果指定了utf-8,Python 会自动将内部的 Unicode 字符串编码成 UTF-8 格式。

最可靠、最通用的方法(推荐)

这种方法适用于你明确知道原始文件编码的情况,这是最清晰、最不容易出错的方式。

场景 1:原始文件是 GBK(中国大陆 Windows 系统下的 "ANSI")

假设你有一个名为 ansi_text.txt 的文件,其内容是中文,编码为 GBK。

(ansi_text.txt):**

你好,世界!

This is an ANSI file.Python 代码:

# 1. 以 GBK 编码读取文件,解码成 Python 的 Unicode 字符串

try:

with open('ansi_text.txt', 'r', encoding='gbk') as f:

# content 是一个标准的 Python 字符串 (str)

content = f.read()

print("成功读取并解码为 Unicode 字符串:")

print(repr(content)) # 使用 repr() 可以清晰地看到字符串内容

print(content)

# 2. 以 UTF-8 编码写入新文件

with open('utf8_text.txt', 'w', encoding='utf-8') as f:

# Python 会自动将 content 字符串编码为 UTF-8 格式写入

f.write(content)

print("\n文件已成功转换为 UTF-8 并保存为 utf8_text.txt")

except FileNotFoundError:

print("错误:文件 ansi_text.txt 未找到。")

except UnicodeDecodeError:

print("错误:文件不是 GBK 编码,解码失败。")

except UnicodeEncodeError:

print("错误:文件包含无法用 UTF-8 编码的字符。")

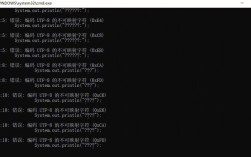

执行结果:

成功读取并解码为 Unicode 字符串:

'你好,世界!\nThis is an ANSI file.\n'

你好,世界!

This is an ANSI file.

文件已成功转换为 UTF-8 并保存为 utf8_text.txt用文本编辑器打开 utf8_text.txt,你会发现它的编码已经是 UTF-8,并且内容正确。

场景 2:原始文件是 Windows-1252(英文 Windows 系统下的 "ANSI")

如果文件来自英文 Windows 系统,你需要使用 cp1252 编码。

# 假设文件 'ansi_text.txt' 的编码是 cp1252

# 它可能包含特殊的引号 “ ” ‘ ’

# 1. 以 cp1252 编码读取

try:

with open('ansi_text.txt', 'r', encoding='cp1252') as f:

content = f.read()

print("成功读取并解码为 Unicode 字符串:")

print(repr(content))

# 2. 以 UTF-8 编码写入

with open('utf8_text.txt', 'w', encoding='utf-8') as f:

f.write(content)

print("\n文件已成功从 CP1252 转换为 UTF-8")

except UnicodeDecodeError:

print("错误:文件不是 CP1252 编码。")

处理字节流(Bytes)

如果你从一个二进制模式读取了文件,或者得到的是字节串(bytes),你需要先手动解码它。

# 假设我们有一个 GBK 编码的字节串

gbk_bytes = '你好,世界!'.encode('gbk')

print(f"原始字节串: {gbk_bytes}")

print(f"字节串的解码类型: {type(gbk_bytes)}")

# 1. 使用正确的编码('gbk')将字节串解码为字符串

try:

decoded_string = gbk_bytes.decode('gbk')

print(f"\n解码后的字符串: {decoded_string}")

print(f"解码后的类型: {type(decoded_string)}")

# 2. 将字符串编码为 UTF-8 字节串

utf8_bytes = decoded_string.encode('utf-8')

print(f"\n重新编码为 UTF-8 字节串: {utf8_bytes}")

print(f"UTF-8 字节串的解码类型: {type(utf8_bytes)}")

# 3. (可选) 将 UTF-8 字节串写入文件

with open('from_bytes_utf8.txt', 'wb') as f:

f.write(utf8_bytes)

except UnicodeDecodeError:

print("解码失败,请检查编码是否正确。")

关键点:

.decode():将bytes->str,必须指定原始编码。.encode():将str->bytes,指定你想要的目标编码(如'utf-8')。

如何处理“未知”的 ANSI 编码(自动检测)

有时你无法确定文件的具体编码,只知道它可能是某种“ANSI”编码,这时可以使用第三方库 chardet 来自动检测编码。

安装 chardet

pip install chardet

使用 chardet 进行检测

import chardet

# 假设我们有一个不确定编码的文件 'unknown_encoding.txt'

# 它的编码很可能是 GBK

# 1. 以二进制模式 ('rb') 读取文件

with open('unknown_encoding.txt', 'rb') as f:

raw_data = f.read()

# 2. 使用 chardet 检测编码

result = chardet.detect(raw_data)

encoding = result['encoding']

confidence = result['confidence']

print(f"检测到的编码: {encoding}")

print(f"置信度: {confidence:.2f}")

# 3. 根据检测结果进行解码

if confidence > 0.9: # 设置一个置信度阈值

try:

# 使用检测到的编码来解码字节流

content = raw_data.decode(encoding)

print("\n成功解码内容:")

print(content)

# 4. 转换并保存为 UTF-8

with open('detected_utf8.txt', 'w', encoding='utf-8') as f:

f.write(content)

print("\n文件已根据检测结果转换为 UTF-8。")

except UnicodeDecodeError:

print(f"\n尽管检测到 {encoding},但解码仍然失败。")

else:

print("\n置信度过低,无法确定编码。")

chardet 的局限性:

- 它不是 100% 准确的,特别是对于非常短的文本。

- 对于 GBK 和 BIG5 等中文编码,有时可能会混淆。

- 它是一个“尽力而为”的工具,在无法确定编码时非常有用,但在已知编码的场景下,明确指定编码(如方法一)永远是更优的选择。

总结与最佳实践

| 场景 | 推荐方法 | 示例代码 |

|---|---|---|

| 明确知道编码是 GBK | 直接指定编码 | with open('f.txt', 'r', encoding='gbk') as f: |

| 明确知道编码是 CP1252 | 直接指定编码 | with open('f.txt', 'r', encoding='cp1252') as f: |

已有字节串 (bytes) |

先解码,再编码 | s = my_bytes.decode('gbk'); utf8_bytes = s.encode('utf-8') |

| 文件来源不明,疑似ANSI | 使用 chardet 检测 |

import chardet; r = chardet.detect(raw_data); s = raw_data.decode(r['encoding']) |

| 处理网络流或管道数据 | 方法二或三 | 从网络或 subprocess 获取的通常是字节流,需要先解码。 |

核心原则:

- 尽早解码,延迟编码:一旦从外部来源(文件、网络、数据库)获取了数据,就应立即将其解码为 Python 的内部字符串 (

str)进行处理,只在需要写入或发送时,才将其编码为目标格式(如utf-8)。 - 明确优于猜测:如果你能确定文件的编码,永远不要依赖自动检测,直接在

open()函数或.decode()方法中明确指定编码,这是最健壮、最清晰的代码。 - 处理异常:文件操作和编解码都可能失败(如文件不存在、编码错误),使用

try...except块来优雅地处理这些错误,让你的程序更稳定。