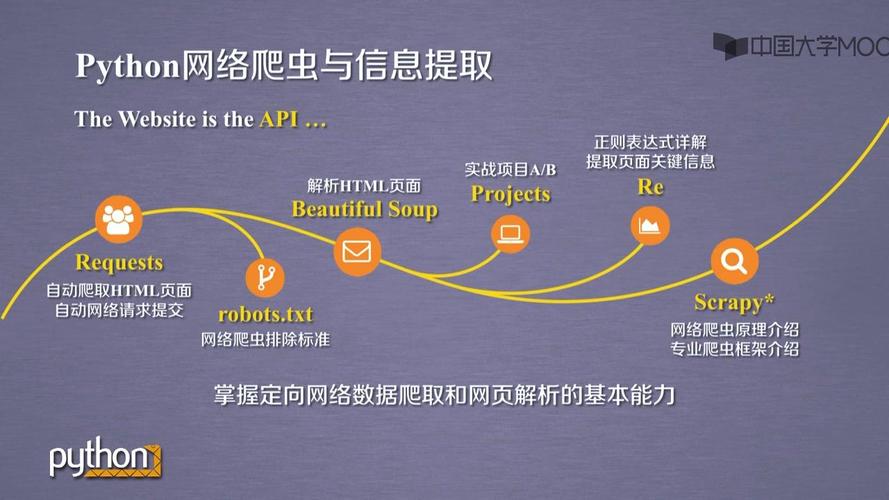

Python在网络爬虫领域拥有非常丰富和强大的第三方库生态系统,这些库覆盖了从简单的静态页面抓取到复杂的动态页面渲染、数据解析、异步请求等方方面面。

下面我将这些库按照功能层次和用途进行分类介绍,并附上它们的特点和适用场景。

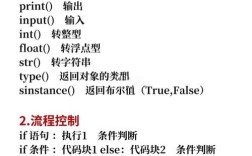

核心请求库

这类库是爬虫的“腿脚”,负责向服务器发送HTTP/HTTPS请求并接收响应。

requests - 人性化的HTTP库

这是Python爬虫领域最流行、最基础的库,没有之一。

-

特点:

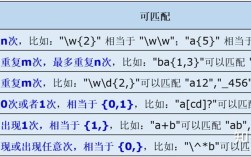

(图片来源网络,侵删)

(图片来源网络,侵删)- API设计简洁优雅,易于上手。

- 功能强大,支持自动内容解码、会话保持、Cookie管理、文件上传、流式下载等。

- 内置了从

urllib3继承的、功能强大的连接池。

-

适用场景:

- 绝大多数静态网页的数据抓取。

- 需要模拟登录、处理Cookie的场景。

- 快速原型开发和简单的脚本任务。

-

简单示例:

import requests url = 'https://www.example.com' response = requests.get(url) # 检查请求是否成功 response.raise_for_status() # 打印网页内容 print(response.text)

urllib - Python标准库

Python内置的HTTP请求库,无需安装。

- 特点:

- 无需安装,随Python一起发布。

- 功能比较基础,但非常稳定。

- API相对繁琐,不如

requests直观。

- 适用场景:

- 不想安装第三方依赖的轻量级任务。

- 在某些受限环境(如某些嵌入式系统)下使用。

requests无法满足某些特殊底层需求时,可以回退到urllib。

动态页面渲染库

现代网站大量使用JavaScript(Vue, React, Angular等框架)来动态加载数据,传统的requests只能获取到初始的HTML,而无法执行JS,因此需要使用这类库。

Selenium - Web自动化测试框架

这是最著名、最成熟的浏览器自动化工具,常被用作爬虫。

- 特点:

- 通过驱动真实的浏览器(如Chrome, Firefox)来模拟用户操作。

- 可以处理复杂的JavaScript渲染、点击、填写表单、等待元素加载等。

- 支持多种编程语言(Python, Java, C#等)。

- 适用场景:

- 抓取由JavaScript动态生成内容的网页。

- 需要模拟用户登录、点击、翻页等交互行为的网站。

- 进行网页截图或录制操作流程。

- 注意: 相对较慢,资源消耗大,应作为最后的选择,优先尝试分析API接口。

Playwright - 现代化浏览器自动化库

由微软开发,是Selenium的强力竞争者,近年来非常流行。

- 特点:

- 速度快:基于Node.js和Python,性能优于Selenium。

- 自动化能力强:支持自动等待、网络拦截、多浏览器/多标签页管理。

- API设计优秀:链式调用,代码更简洁。

- 对异步/同步支持都很好。

- 适用场景:

- 与Selenium类似,但需要更高性能、更强自动化能力的场景。

- 尤其适合处理复杂的现代Web应用。

Pyppeteer - Python版的Puppeteer

Puppeteer是Node.js下的著名库,Pyppeteer是其Python封装,使用无头版Chromium。

- 特点:

- 功能与Puppeteer几乎一致,但Python调用。

- 无头模式运行,节省资源。

- 对Chrome DevTools Protocol有很好的支持。

- 适用场景:

需要精细控制浏览器行为的爬虫。

解析库

获取到网页源码(HTML或JSON)后,需要用解析库来提取我们想要的数据。

Beautiful Soup - HTML/XML解析库

简单、灵活、强大的HTML解析库,非常适合初学者。

-

特点:

- 容错性强,能很好地处理“不完美”的HTML。

- 支持多种解析器(如

lxml,html.parser)。 - 提供了非常方便的API(如

find(),find_all(),select())来遍历和搜索DOM树。

-

适用场景:

- 解析HTML和XML文档,提取结构化数据。

- 与

requests库配合,是静态网页爬虫的“黄金搭档”。

-

简单示例:

from bs4 import BeautifulSoup import requests html_doc = """ <html><head><title>The Dormouse's story</title></head> <body> <p class="title"><b>The Dormouse's story</b></p> <p class="story">Once upon a time...</p> </body> </html> """ soup = BeautifulSoup(html_doc, 'html.parser') print(soup.title.string) # 输出: The Dormouse's story print(soup.find('p', class_='title').text) # 输出: The Dormouse's story

lxml - 高性能的XML/HTML解析库

速度极快,功能强大的解析库,也是Beautiful Soup的推荐解析器。

- 特点:

- 解析速度非常快,性能远超Python内置的

html.parser。 - 支持XPath 1.0,强大的数据提取能力。

- 功能全面,支持XML和HTML。

- 解析速度非常快,性能远超Python内置的

- 适用场景:

- 对性能要求高的爬虫项目。

- 需要使用XPath进行复杂、精确的数据定位。

pyquery - jQuery风格的解析库

如果你熟悉jQuery的语法,pyquery会让你感到非常亲切。

- 特点:

- API设计与jQuery几乎完全一样。

- 强大的CSS选择器支持。

- 适用场景:

- 前端开发者,习惯jQuery语法。

- 需要灵活使用CSS选择器进行数据提取。

高性能异步爬虫库

当需要爬取大量网址时,传统的同步爬虫(如requests + BeautifulSoup)效率低下,这时就需要异步框架。

aiohttp - 异步HTTP客户端/服务器库

requests的异步版本,是构建异步爬虫的基础。

- 特点:

- 基于Python的

asyncio库,实现非阻塞I/O。 - 可以在单个线程内并发处理成千上万的请求,速度极快。

- API设计上与

requests相似,易于学习。

- 基于Python的

- 适用场景:

- 高并发、大规模的数据抓取任务。

- 需要频繁请求API接口的场景。

Scrapy - 爬虫框架

一个功能全面的、成熟的爬虫框架,是构建大型、健壮爬虫的首选。

-

特点:

- 框架化:提供了从URL管理、数据抓取、解析到数据存储的完整解决方案。

- 异步核心:底层使用

Twisted(异步网络引擎),天生支持高并发。 - 强大的中间件系统:可以轻松地扩展功能,如代理IP、User-Agent轮换、反爬虫策略等。

- 数据导出:支持将数据导出为JSON, CSV, XML等多种格式。

- 可扩展性:项目结构清晰,易于维护和扩展。

-

适用场景:

- 中大型、持续运行的企业级爬虫项目。

- 需要遵守

robots.txt、处理反爬策略的复杂网站。 - 需要构建分布式爬虫(

Scrapy提供了Scrapy-Redis等扩展)。

-

简单示例 (概念性):

# 在Scrapy项目中,一个Spider类看起来像这样 import scrapy class QuotesSpider(scrapy.Spider): name = 'quotes' start_urls = ['http://quotes.toscrape.com/'] def parse(self, response): for quote in response.css('div.quote'): yield { 'text': quote.css('span.text::text').get(), 'author': quote.css('small.author::text').get(), } # 翻页逻辑 next_page = response.css('li.next a::attr("href")').get() if next_page is not None: yield response.follow(next_page, callback=self.parse)

其他实用工具库

fake-useragent - 生成随机User-Agent

用于伪装浏览器身份,防止被网站识别为爬虫。

- 特点:

- 维护了一个庞大的浏览器User-Agent列表。

- 可以随机生成或指定浏览器的User-Agent。

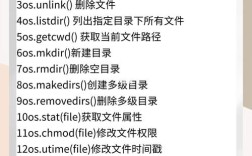

pymongo - MongoDB Python客户端

如果需要将爬取的数据存储到NoSQL数据库(如MongoDB)中,这个库是必需的。

pandas - 数据分析库

用于处理和清洗爬取到的结构化数据,并进行初步分析。

总结与选择建议

| 库名 | 类型 | 核心特点 | 适用场景 |

|---|---|---|---|

requests |

请求库 | 简单、优雅、功能全面 | 入门首选,绝大多数静态页面 |

Selenium |

动态渲染 | 真实浏览器模拟,强大但慢 | JS渲染页面,需要模拟用户操作 |

Playwright |

动态渲染 | 快速、现代、自动化能力强 | 高性能JS渲染,复杂自动化任务 |

Beautiful Soup |

解析库 | 简单易用,容错性强 | 解析HTML,与requests搭配 |

lxml |

解析库 | 速度极快,支持XPath | 对性能要求高,需要XPath |

aiohttp |

异步库 | 基于asyncio,高并发 | 大规模、高效率的请求 |

Scrapy |

爬虫框架 | 框架化,异步,功能强大 | 中大型项目,企业级爬虫 |

如何选择?

- 新手入门/简单任务:从

requests+Beautiful Soup开始,这是最经典、最易于上手的组合。 - 处理JS渲染页面:优先尝试分析网站的网络请求(F12 -> Network),直接请求API接口,如果不行,再考虑

Playwright(推荐)或Selenium。 - 大规模/高性能爬取:使用

aiohttp+asyncio构建异步爬虫。 - 构建健壮、可维护的项目:直接使用

Scrapy框架,它能帮你解决很多底层问题,让你专注于业务逻辑。